Si è tenuto lo scorso 8 febbraio il Workshop dell’Osservatorio TeSeM (Tecnologie e Servizi per la Manutenzione, www.tesem.net) dal titolo “La digital transformation della manutenzione: come gestire il cambiamento nelle operation degli impianti industriali e delle infrastrutture?”. Il workshop era l’ultimo della ricerca d’anno del TeSeM. I partecipanti, circa 40, presenti all’evento su invito, provenivano da diversi settori degli impianti industriali e delle infrastrutture. Inoltre, era rappresentata l’intera filiera come catena del valore, dalla componente degli End-user – vale a dire, i gestori degli impianti industriali e delle infrastrutture –, che contava per oltre la metà dei partecipanti, agli OEM, Technology provider, Service Provider, ed EPC. A fare da padrone di casa è stato Marco Macchi, responsabile scientifico dell’Osservatorio, oltre che direttore della rivista Manutenzione T&M: a lui è spettato il compito di introdurre i lavori, di presentare l’Osservatorio, la sua storia e le ricerche compiute dall’anno della sua istituzione, il 2010.

Il workshop ha permesso di dare vita ad un ampio dibattito su una tematica sempre più attuale nel mondo della manutenzione, consentendo di discutere i fattori necessari per il successo della digital transformation dei processi industriali, con particolare attenzione alla manutenzione. Macchi, insieme a Luca Fumagalli e Irene Roda, direttori della ricerca dell’Osservatorio, hanno svolto il ruolo di facilitatori del dibattito e del confronto tra i partecipanti all’evento.

La mattinata è stata avviata da un breve momento introduttivo, a cura dell’Osservatorio, sui concetti fondanti della digitalizzazione della manutenzione. In seguito, sono state presentate tre diverse prospettive della trasformazione digitale, a cura di Agomir, SAS e Siemens. Ciò ha permesso di portare i primi spunti di riflessione della giornata, rivolti alla interpretazione delle sensibilità di una parte della catena del valore, in uno spettro di temi ampio, a partire dalle soluzioni tecnologiche e di service per supportare il percorso trasformativo, sino al cambiamento che può prospettarsi sempre più nei modelli di business e nelle relazioni industriali. In seguito, si è aperto un ampio dibattito e confronto che ha portato a testimonianze varie con l’intervento degli esponenti delle diverse aziende presenti.

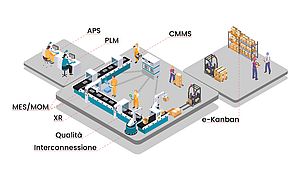

La discussione si è focalizzata su vari aspetti della trasformazione digitale: dalla definizione di Manutenzione nel quadro dell’Industria 4.0, al ruolo della trasformazione digitale nell’evoluzione della gestione degli asset industriali e della manutenzione, passando per altri aspetti del processo di trasformazione, tra cui la vision del cambiamento in manutenzione ottenibile con la digitalizzazione e l’importanza della collaborazione, dentro e di fuori dell’azienda, a sostegno del percorso evolutivo della trasformazione digitale della manutenzione. È questa solo una limitata selezione degli aspetti tipici della digital transformation della manutenzione che sono stati affrontati e che hanno dato modo di creare un autentico dibattito, molto vivace, tra i protagonisti della giornata.

L’Osservatorio concluderà i lavori della ricerca d’anno con il Convegno finale della ricerca 2016-17, durante il quale verrà presentato il report pubblicato a stampa dal titolo “Manutenzione nell’industria 4.0: Quali strategie per governare la trasformazione digitale?”. Il Convegno, il quarto della serie di convegni nati dalla istituzione dell’Osservatorio, è programmato per il prossimo martedì 17 aprile, dalle 14.30, e sarà ospitato da i.lab Italcementi (ulteriori informazioni sul sito www.tesem.net).

Marco Marangoni