O&M è un termine che ben sintetizza il forte vincolo tra le due componenti strategiche di un’organizzazione: Operation & Maintenance. Un legame che esplicita come l’attività di una abbia un impatto vicendevole e determinante sull’attività dell’altra. Sulla carta, nella gestione organica di un asset complesso e strutturato, sia di processo sia manifatturiero, è sempre così, pur con differenti pesi, perché entrambe le funzioni insistono sugli stessi processi organizzativi, anche se con gerarchie e ruoli differenti a seconda del processo. Esistono, però, ambiti (aziende di processo e gestione impianti energia) dove l’interdipendenza tra le due distinte funzioni organizzative, è sostanziale, continua e obbligata, non solo formale e forzata. In questi casi, tale interdipendenza “forte” ha i suoi principali effetti e si manifesta sul patrimonio informativo a supporto della gestione, quasi sovrapposto, pur cambiando le modalità di condivisione sul fronte dell’analiticità dei dati e delle rispettive priorità.

Occorre quindi condividere, per una reciproca comprensione tra le due funzioni organizzative, gli stessi dati e le stesse informazioni. Tutto ciò è necessario anche se l’utilizzo risulterà differente, sia nelle modalità sia nelle finalità.

Fatta questa necessaria premessa, in un mondo industriale sempre più complesso e competitivo, con una tensione crescente verso lo sviluppo sostenibile e aspetti di obbligatorietà, normativi o volontarii, le opzioni di investimento e le priorità operative ordinarie portano a continue scelte su quali elementi privilegiare e quali procrastinare. Devono essere scelte consapevoli e motivabili: ciò si raggiunge solo se prese con un approccio basato su un’“analisi di rischio” quindi un “Indice Rischio”, elemento il più possibile oggettivo.

Tale approccio deve considerare il Rischio quale elemento utile per valutare ogni evento critico aziendale: da un evento grave o catastrofico, a un evento negativo con impatto più limitato. Allo stesso tempo, un Indice di Rischio che consideri l’impatto dell’evento per ogni lato del problema: sull’Asset (costi diretti e indiretti), sulla Produzione (costi dei fermi/rallentamenti, di degrado qualità, mancata produzione), sulla Reputation aziendale, e, ultimo ma non ultimo, sul Safety & Environment, che in taluni settori è fattore di estrema criticità.

Ne consegue che l’intera gestione dovrebbe rispondere a questo principio; quindi, parliamo di applicazione di metodologie HazOp/FTA (Fault Tree Analysis) per valutare il rischio di Eventi negativi, e di FMECA/MAGEC e storia manutentiva per valutare la criticità di macchine e componenti, in sintesi di RBM (Risk Based Maintenance and Operation).

Tutto ciò, però, non è sufficiente, e per far sì che l’oggettività non diventi solo formale, il Rischio deve diventare un elemento continuo, dinamico, che non si limiti, come accade, alla fotografia di uno scenario progettuale o periodico, ma che diventi il vero elemento di controllo continuativo e di supporto alle decisioni.

Tali approcci metodologici HazOp e FMECA non sono certo nuovi, ma devono poter rivivere, riacquisendo significatività, e ciò è possibile solo se diventano “Dynamic Risk Analysis”. A riguardo, si possono raggiungere obiettivi inaspettati, grazie al patrimonio informativo sempre più ampio, per la crescente digitalizzazione, con disponibilità di “digital twin” di sistemi fisici, associati a quanto proviene dal mondo M2M (Machine to Machine) grazie a I4.0, e, in aggiunta, ai dati dal mondo H2M (Human To Machine). L’uso ottimale di tali dati consente di superare il limite della staticità andando verso un vero e proprio “Dynamic Risk Analysis”: quindi RTRM (Real Time Risk Management) , ma allo stesso tempo di prevedere e anticipare sempre meglio gli eventi negativi, sin dai primi segnali.

Di seguito un’analisi delle famiglie di soluzioni nel tema Digitalizzazione maggiormente impattanti, per gli obiettivi che rientrano nella gestione degli asset, anche se oramai qualsiasi innovazione, di processo organizzativo operativo o di ingegneria, di impianto o di processo produttivo in senso ampio (revamping), di M&O di campo, include componenti, tecnologici.

Un’accelerazione molto evidente è avvenuta nella famiglia di soluzioni tecnologiche di diagnostica, a partire da CBM fino a quelle predittive. Queste tecnologie hanno raggiunto livelli altissimi di affidabilità, grazie a componenti di campo, spesso intelligenti, con funzioni autonome di diagnostica, interconnesse a Fog o Edge computing, a loro volta inclusi in architetture connesse a piattaforme progettate per operare su scale sempre maggiori, arrivando a comparare, anche in real time, parametri funzionali di macchine uguali che operano in situazioni e siti diversi.

Una seconda accelerazione è avvenuta nelle architetture con componenti collegati “mobile & device” (HoloLens, Pad, RFId, NFT, Radar), che danno possibilità agli operatori di decentrare le informazioni sul campo, rendendo l’utilizzo degli stessi sempre più user friendly, migliorando i processi.

Tutto ciò, in sintesi, porta a benefici tangibili, ma è presente ancora qualche criticità che deve essere gestita.

Sul fronte della diagnostica, è necessaria un’integrazione più capillare tra le varie tecniche e una migliore gestione dei dati all’interno dei processi manutentivi: compiti, propri dell’Ingegneria di Manutenzione, che spesso vengono posticipati. Deficit di integrazione informativa sono presenti anche se le piattaforme software di gestione (ERP-EAM) sono già native SOA (Service Oriented Architecture), quindi predisposte, ma il tema viene gestito da IT che non ne vede la priorità, quando invece per l’Ingegneria di Manutenzione rappresenta un problema cardine.

L’aspetto formativo e in generale di conflitto generazionale sull’uso delle tecnologie, da elemento critico è diventato un fattore in progressiva metabolizzazione, in virtù del fatto che le tecnologie utilizzate, diventano sempre più intuitive e mature, beneficiando dei anche progressi di quelle a largo consumo. La crescita di utilizzo di applicazioni software standard di mercato (meno custom) e sempre più economiche aumenta l’entropia informativa e l’uso destrutturato, con conseguenti inefficienze sui processi; tali inefficienze, però, vengono mitigate dalla crescita informativa inarrestabile nel M2M.

Tutto ciò, in conclusione, influenza il processo di condivisione del patrimonio informativo, e interessa diversi elementi: sistemi informativi e tecnologie di base. La capacità di interoperare, quindi, e di creare “data mining” è centrale.

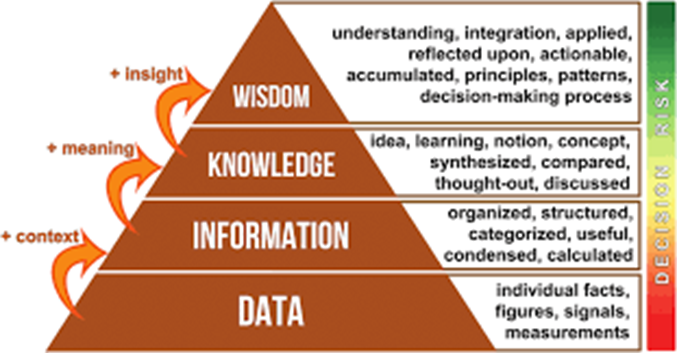

Ma il vero aspetto cruciale è la capacità di estrarre poi dai dati il massimo “valore”, per dare le risposte giuste ai temi sopra riportati. Per concludere, quindi i dati crescono, diventano informazioni (vedi immagini DIKW, livello 2), ma solo con difficoltà scalano piramide, per raggiungere il livello 3 (solo in parte). È necessaria l’Ingegneria di Manutenzione (IdM), quindi metodologie RAMS applicate, per arrivare all’ ultimo livello, e oltrepassarlo.

Questo tema, è destinato a un’evoluzione significativa, con un impatto impressionante e senza precedenti, in particolare sul fronte dell’utilizzo di funzioni sempre più Esperte con conseguenze epocali sul fronte predittivo (diagnostico e prognostico), in tema di comportamenti e guasti di componenti/macchine/impianti, ma soprattutto di sistemi complessi, e sul fronte delle ottimizzazioni e simulazioni di processo produttivo, creando gap competitivi, difficili da colmare, tra chi le userà o meno; gap che giocheranno una partita determinante sul fronte dell’esistenza o meno di certe realtà e relative produzioni, un tema per futuri approfondimenti.